Eu vou mostrar rapidamente como criar um arquivo robots.txt. O arquivo robots é usado para instruir os robôs do mecanismo de pesquisa sobre quais páginas do seu site devem ser rastreadas e, consequentemente, indexadas. Essa é uma introdução para um dos mais importantes arquivos para web sites.

A maioria dos sites tem arquivos e pastas que não são relevantes para os mecanismos de pesquisa, como: imagens ou arquivos administrativos. Portanto, criar um arquivo robots.txt pode realmente melhorar a indexação do site.

O que é um arquivo robots.txt?

Um arquivo robots.txt é um conjunto de instruções para bots . Este arquivo está incluído nos arquivos de origem da maioria dos sites. Os arquivos Robots.txt destinam-se principalmente a gerenciar as atividades de bons bots, como rastreadores da web , uma vez que bots ruins provavelmente não seguirão as instruções.

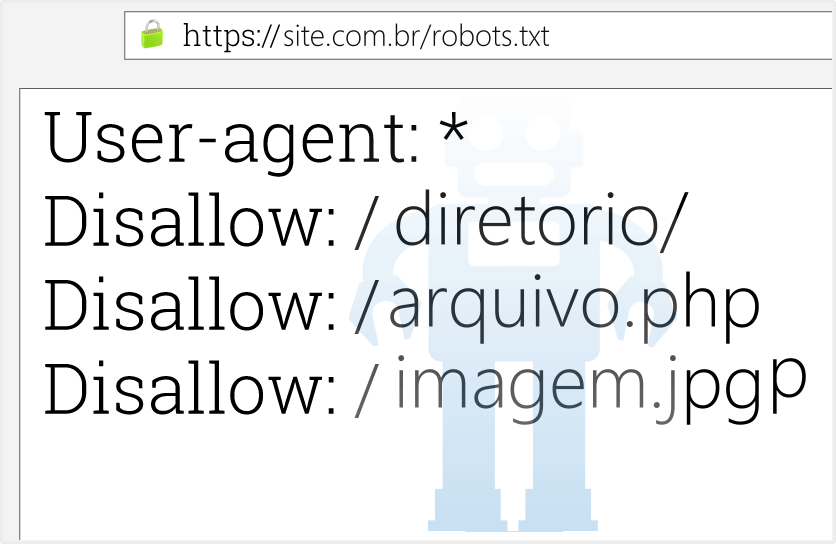

Na prática, os arquivos robots.txt indicam se certos agentes de usuário; software de rastreamento da web; podem ou não rastrear partes de um site. Essas instruções de rastreamento são especificadas para proibir ou permitir o comportamento de determinados agentes do usuário.

Um robô é um arquivo de texto simples que pode ser criado com o Bloco de Notas. Se você estiver usando o WordPress, um arquivo robots.txt de amostra seria:

User-agent: * Disallow: /wp- Disallow: /feed/ Disallow: /trackback/

“User-agent: *” significa que todos os robôs de pesquisa (do Google, Yahoo, MSN e assim por diante) devem usar essas instruções para rastrear seu site. A menos que seu site seja complexo, você não precisará definir instruções diferentes para diferentes aranhas.

Disallow, que dizer não permitir: / wp-, por exemplo. Isso garantirá que os mecanismos de pesquisa não rastrearão os arquivos do WordPress. Esta linha irá excluir todos os arquivos e dobras começando com "wp-" ?? da indexação, evitando conteúdo duplicado e arquivos administrativos.

Se você não estiver usando o WordPress, basta substituir as linhas Disallow por arquivos ou pastas em seu site que não devem ser rastreados, por exemplo:

User-agent: * Disallow: /images/ Disallow: /cgi-bin/ Disallow: /todas as pastas que deseja excluir/

Depois de criar o arquivo robots.txt, basta enviá-lo para o diretório raiz e pronto. Se você quiser mais recursos com indexação de páginas, também deve criar um sitemap.xml e enviar ao Google Console.

Por que arquivo Robots no formato txt é importante?

A maioria dos sites não precisa de um arquivo robots.txt.

Isso ocorre porque o Google geralmente pode localizar e indexar todas as páginas importantes do seu site.

E eles NÃO indexarão automaticamente páginas que não são importantes ou duplicarão versões de outras páginas.

Dito isso, há três motivos principais pelos quais você deseja usar um arquivo robots.txt.

Bloquear páginas não públicas: às vezes, você tem páginas em seu site que não deseja indexadas. Por exemplo, você pode ter uma versão de teste de uma página. Ou uma página de login. Essas páginas precisam existir. Mas você não quer que pessoas aleatórias pousem neles. Este é o caso em que você usaria o robots.txt para bloquear essas páginas dos rastreadores e bots do mecanismo de pesquisa.

Maximize o orçamento de rastreamento: se estiver tendo dificuldade para indexar todas as suas páginas, você pode ter um problema de orçamento de rastreamento . Ao bloquear páginas sem importância com o robots.txt, o Googlebot pode gastar mais do seu orçamento de rastreamento nas páginas que realmente importam.

Impedir a indexação de recursos: o uso de meta diretivas pode funcionar tão bem quanto Robots.txt para evitar que as páginas sejam indexadas. No entanto, as meta diretivas não funcionam bem para recursos de multimídia, como PDFs e imagens. É aí que o robots.txt entra em jogo.